研究人员提出基于课程的深度强化学习框架 旨在提高电动车路径规划的速度和可靠性

盖世汽车讯 据外媒报道,迈阿密大学(University of Miami))的Mertcan Daysalilar、塞浦路斯国际大学(Cyprus International University)的Fuat Uyguroglu、密苏里科技大学(Missouri University of Science and Technology)的Gabriel Nicolosi等研究人员提出了一种基于课程的深度强化学习框架,旨在提高电动车路径规划解决方案的速度和可靠性。

图片来源:https://arxiv.org/abs/2601.15038

现有的深度强化学习模型在面对此类问题的复杂约束时往往表现不佳,但这种新方法采用了一种分阶段学习系统,逐步增加难度,从而确保训练的稳定性和出色的泛化能力,即使在处理多达100个客户的问题时,也能保持良好的性能,而其训练样本规模要小得多。这一突破为在实际应用中实现实用、高效且可靠的电动车路径规划迈出了重要一步。

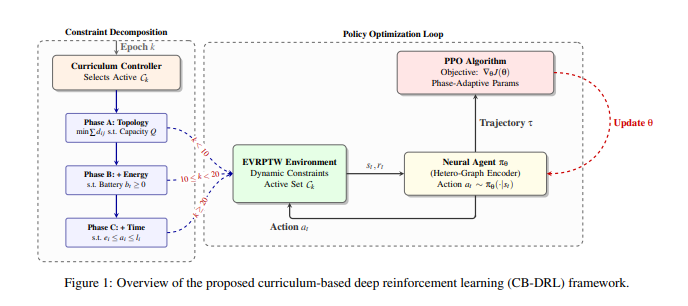

研究团队设计了一个结构化的三阶段课程,逐步增加问题的复杂性,使智能体能够先掌握距离和车队优化,然后是电池管理,最终掌握完整的电动车道路运输(EVRPTW)场景。这种分阶段的方法规避了通常困扰端到端深度强化学习(DRL)模型的稀疏奖励信号问题,从而促进了稳定的学习并防止策略崩溃。

为了确保每个阶段学习的一致性,团队实现了一种改进的近端策略优化算法,精心调优了超参数,采用了价值和优势裁剪,并利用了自适应学习率调度。该模型的核心在于一个异构注意力编码器,它结合了全局-局部注意力机制和特征级线性调制。这种专门设计的架构旨在明确捕捉仓库、客户以及至关重要的充电站的独特特征,使智能体能够根据能源约束做出明智的路径选择。该模型最初在仅包含N=10个客户的小型实例上进行训练,展现出了卓越的泛化能力,成功处理了N=5到N=100的未见过实例。

实验表明,这种课程引导式方法在分布式场景下实现了高可行性率和具有竞争力的解决方案质量,显著优于在密集约束下经常失效的标准深度强化学习(DRL)基线方法。该团队的工作有效地弥合了神经网络的速度与实际物流所需的运行可靠性之间的差距。通过将问题分解为可管理的阶段,CB-DRL框架使智能体能够学习到一种能够应对EVRPTW复杂性的鲁棒策略,为可持续和高效的配送运营提供了一种极具前景的解决方案。这项创新有望显著改进动态实时环境下电动车车队的规划和执行。

针对电动车路径问题(EVRPTW)的三阶段学习课程,循序渐进地提升技能

科学家们开发了一种基于课程的深度强化学习(CB-DRL)框架,旨在解决电动车路径问题(EVRPTW)求解过程中存在的稳定性问题。该研究率先提出了一种结构化的三阶段课程,逐步增加问题的复杂性,从而提升训练的稳定性和泛化能力。首先,智能体在A阶段学习距离和车队优化;随后在B阶段学习电池管理;最终在C阶段学习完整的EVRPTW算法。这种分阶段的方法有效应对了复杂路径问题中常见的密集约束挑战。

为了确保每个阶段学习的稳定性,研究人员采用了一种改进的近端策略优化算法,并针对每个阶段精心调整了超参数。此外,他们还实现了价值和优势裁剪以及自适应学习率调度,进一步优化了学习过程。策略网络本身基于异构注意力编码器构建,并结合了全局-局部注意力机制和特征级线性调制,这是一项关键的架构创新。这种专门的设计能够明确地捕捉仓库、客户和充电站的独特属性,使模型能够区分它们在路径规划问题中的角色。

该团队设计了一种异构图注意力编码器,能够有效地将EVRPTW表示为一个图,并充分考虑了每种节点类型的不同功能。与标准注意力模型不同,该编码器使用独立的投影参数WQcust、WQstation和WQdepot,使模型能够学习节点间不同的关系动态。例如,客户与充电站之间的距离与两个充电站之间的距离权重不同,这反映了客户与充电站之间距离对路径可行性的重要性。生成的嵌入随后由全局-局部注意力边缘编码器进行处理,该编码器将局部邻域信息与全局路径上下文融合,从而聚合不同空间尺度的特征。

实验采用包含N=10个客户的实例进行训练,结果表明该模型能够很好地泛化到N=5到N=100的未见过实例。在中等规模的问题上,该模型显著优于标准基线方法,即使在传统深度强化学习方法失效的分布外实例上,也能实现高可行性率和具有竞争力的解质量。这种课程引导式方法有效地弥合了计算速度和运行可靠性之间的差距,展现了结构化学习在复杂优化任务中的强大能力。

具体而言,课程引导式方法在传统深度强化学习(DRL)基线方法始终失效的非分布式实例上实现了高可行性率和具有竞争力的解决方案质量。测量结果证实,CB-DRL框架能够成功应对EVRPTW中固有的稀疏奖励信号,避免了因频繁违反约束(例如电池耗尽或错过截止时间)而导致的不稳定性,而这些不稳定性正是标准端到端强化学习模型的通病。该突破性成果提供了一种将路径拓扑学习与复杂约束下的可行性保证分离的方法,使智能体能够先学习可行路径,然后再优化配送时间。测试证明,三阶段课程使神经策略能够在基准实例上实现接近最优的性能和零样本泛化能力。目标函数定义为最小化总行驶距离和车队规模(权重因子为λ),该函数已成功优化,证明了该框架能够平衡成本和效率。这项工作为更稳健、可扩展的EVRPTW解决方案奠定了基础,为更可持续、更高效的物流运营铺平了道路。

欢欢@盖世汽车供应链

欢欢@盖世汽车供应链

悠悠@盖世汽车

悠悠@盖世汽车

豆豆@盖世汽车

豆豆@盖世汽车