哥伦比亚大学开发出集成的多模式传感和学习系统 可为机器人提供新功能

盖世汽车讯 为了帮助人类完成家务和其他日常手动任务,机器人应该能够有效地操纵成分、形状和大小各异的物体。过去几年,机器人的操纵技能得到了显著提高,部分原因是摄像头和触觉传感器的发展越来越复杂。

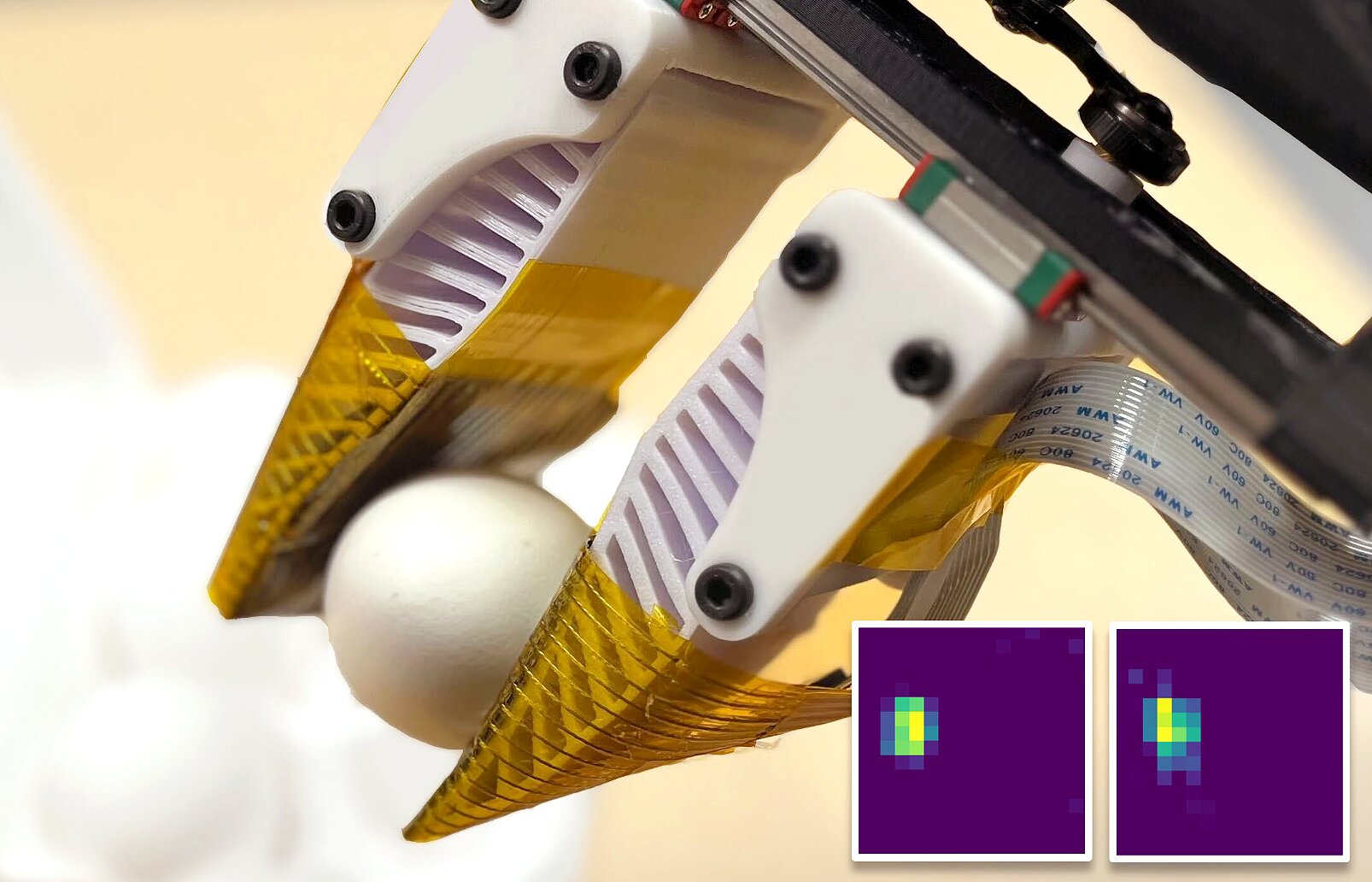

据外媒报道,哥伦比亚大学(Columbia University)的研究人员开发出可以同时捕捉视觉和触觉信息的新系统。该触觉传感器可以集成到机器人夹持器和手上,以进一步增强具有不同身体结构的机器人的操纵技能。相关论文发表在arXiv预印本服务器上。

图片来源:哥伦比亚大学

“人类通过多种感官方式感知环境,其中触觉在理解物理交互方面起着至关重要的作用,”论文的资深作者Yunzhu Li表示。“我们的目标是让机器人具备类似的能力,使它们能够通过视觉和触觉感知环境,以完成精细的机器人操作任务。”

作为研究的一部分,研究人员着手开发一种多模态传感系统,该系统可用于收集视觉数据(可用于估计物体在其视野中的位置及其几何形状)以及触觉信息(例如接触位置、力和局部交互模式)。

该集成多模态传感和学习系统3D-ViTac可以为机器人提供新的传感能力,使它们能够更好地处理现实世界的操作任务。

“与现有的最先进解决方案(尤其是基于光学的传感器)相比,我们的传感器像纸一样薄,灵活、可扩展,并且更适合长期使用和大规模数据收集,”Li解释说。“结合视觉观察,我们开发了一个端到端模仿框架,使机器人能够执行各种操作任务,在与易碎物品的安全交互以及涉及手部操作的长期任务方面表现出显著的改善。”

Li及其同事在一系列采用真实机器人系统的实验中对新开发的传感器和端到端模仿学习框架进行了测试。具体来说,他们将两个片状传感装置集成到机器人夹持器的每个鳍状手上。

随后,该团队在四项具有挑战性的操作任务中测试了夹持器的性能,包括蒸鸡蛋、将葡萄放在盘子上、抓取六角扳手和提供三明治。这些初步测试的结果非常有希望,因为它们的传感器似乎提高了夹持器成功完成所有任务的能力。

“我们证明,我们提出的视觉触觉模仿学习框架甚至可以让低成本的机器人执行精确的操作任务。它的表现明显优于仅使用视觉的方法,特别是在处理易碎物体和实现精细操作的高精度方面,”Li表示。

该研究团队开发的新传感器很快就可以部署到其他机器人系统上,并在需要高精度的更广泛的物体操作任务中进行评估。与此同时,Li及其同事计划开发模拟方法和集成策略,使他们的传感器更容易在其他机器人上应用和测试。

“在我们接下来的研究中,我们的目标是开发触觉信号的模拟技术,探索将传感器集成到灵巧的机器人手和更大规模的表面(例如机器人皮肤)中的方法,并使机器人中的触觉感知变得民主化,”Li补充道。“这将促进大规模数据收集,并有助于建立多模式机器人基础模型,更好地理解通过触摸进行的物理交互。”

欢欢@盖世汽车供应链

欢欢@盖世汽车供应链

悠悠@盖世汽车

悠悠@盖世汽车

豆豆@盖世汽车

豆豆@盖世汽车