中科院研究人员通过创新框架改善场景感知

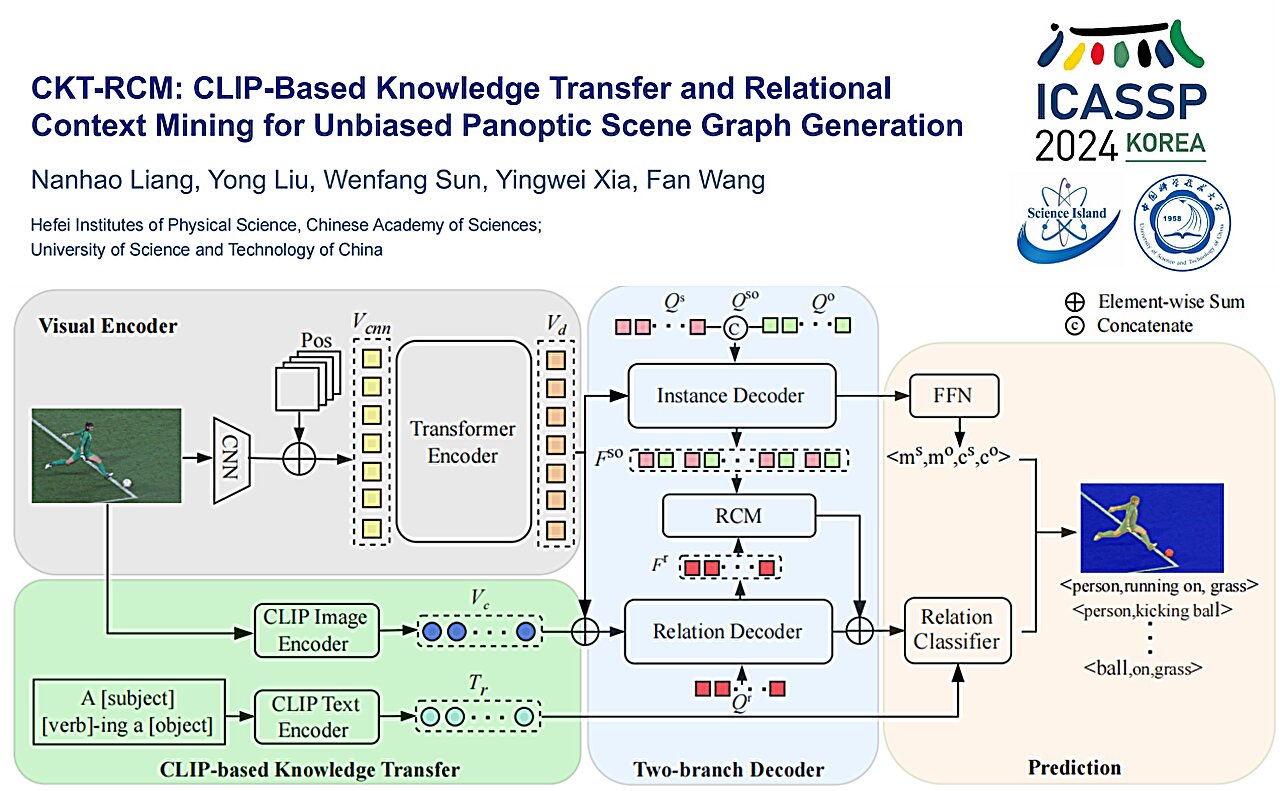

盖世汽车讯 据外媒报道,在中国科学院合肥物质科学研究院刘勇教授的带领下,研究人员提出新框架,即基于视频片段的知识转移和关系上下文挖掘(Clip-based Knowledge Transfer and Relational Context Mining,CKT-RCM),以解决计算机视觉中的长尾分布问题。

图片来源:中科院

全景场景图(PSG)是场景图生成中的一个突出研究方向,需要图像中所有关系的全面输出以及目标定位的精确分割。PSG旨在通过计算机视觉模型提高对场景的理解,并支持场景描述和视觉推理等下游任务。

在这项研究中,研究人员探讨了人类如何感知物体关系,提出了两个关键观点。 人类通常根据常识或先验知识来预测客体关系,并根据主体和客体之间的上下文信息推断关系。

这些观点强调了利用先验知识的重要性:一种涉及使用人类先前观察到的外部数据来纠正数据偏差,而另一种则依赖于对象之间条件的先验分布。

“因此,我们认为充足的先验知识和背景信息对于PSG预测至关重要。”团队成员王帆博士表示。

他们开发了这个网络框架CKT-RCM。基于预训练的视觉语言模型CLIP,CKT-RCM有助于PSG过程中的关系推理。它集成了交叉注意力机制来提取关系上下文,确保关系预测中价值和质量之间的平衡。这项研究有助于机器人和自动驾驶车辆对场景的理解和感知。

欢欢@盖世汽车供应链

欢欢@盖世汽车供应链

悠悠@盖世汽车

悠悠@盖世汽车

豆豆@盖世汽车

豆豆@盖世汽车