国际研究团队研发全新物理AI 可模拟人类用视觉和触觉来操控物体

分享

分享

盖世汽车讯 在日常生活中,从桌上拿起一杯咖啡是一件再简单不过的事。诸如视觉(判断杯子距离)与触觉等多重感官输入会实时融合。然而,要在人工智能(AI)中重现这一过程却并非易事。

据外媒报道,由香港大学(University of Hong Kong)和日本东北大学(Tohoku University)组成的国际研究团队开创了一种新方案,即将视觉与触觉信息融合以用于操控机械臂,并实现环境自适应响应。相较于传统基于视觉信息的方法,这一方案显著提升了任务成功率。这些颇有前景的成果标志着多模态物理AI领域取得重大突破。该团队突破性成果的相关细节发表在《IEEE机器人与自动化快报(IEEE Robotics and Automation Letters)》期刊上。

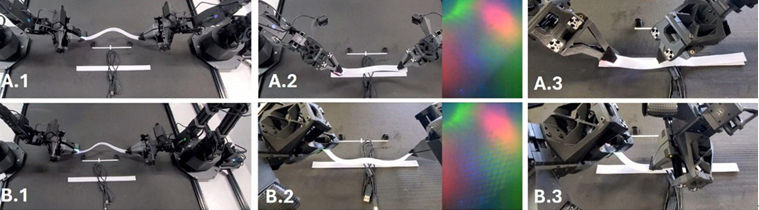

图片来源:东北大学

机器学习可用于支持人工智能(AI)学习人类动作模式,使机器人能够自主执行烹饪、清洁等日常任务。例如,斯坦福大学(Stanford University)开发的ALOHA(一种低成本开源硬件双臂遥操作系统)系统,它可以实现双臂机器人的低成本、多功能远程操作与学习。该系统的硬件与软件均采用开源模式,因此研究团队能够在此基础上开展工作。

然而,这些系统主要仅依赖视觉信息,因此缺乏人类能够做出的触觉判断,比如区分材料质地或物体的正反面。例如,仅通过触摸而非识别外观,这种系统能更容易分辨魔术贴的正面和反面。仅依赖视觉信息而没有其他输入,这是一个令人感到遗憾的弱点。

“为了克服这些局限性,我们开发了一套系统,该系统还能基于目标物体的质地进行操作决策——而仅凭视觉信息难以对这些特征作出准确判断。”日本东北大学的工程研究生院教授Mitsuhiro Hayashibe解释道,“这项成果标志着我们朝着实现多模态物理AI迈出了重要一步,该技术能像我们人类一样整合并处理视觉、听觉和触觉等多重感官信息。”

这一新系统被命名为“触觉阿罗哈”(TactileAloha)。研究人员发现,即使在前后差异和粘附性至关重要的任务中——例如处理魔术贴和扎带——机器人仍能执行恰当的双臂协同操作。他们发现,通过应用视觉-触觉转换器技术,其物理AI机器人展现出更灵活且更具适应性的控制能力。

改进后的物理AI方案通过整合多重感官输入信息以形成自适应响应动作,能精准实现对物体的操控。此类机器人在辅助领域具有近乎无限可能的实用前景。

欢欢@盖世汽车供应链

欢欢@盖世汽车供应链

悠悠@盖世汽车

悠悠@盖世汽车

豆豆@盖世汽车

豆豆@盖世汽车